前言

研究推荐算法的主要痛点是什么?不是文章太少,而是文章太多,信息爆炸。每年KDD、SIGIR、CIKM上,都有那么多中外妈妈一起卖瓜。各种NN、FM、Attention满天飞。其中,不乏真材实料的干货,更不乏揉皱的水文。人们不知道这一点。方法是解决自己问题的灵丹妙药(其实以找手枪的观点看论文也太年轻,太幼稚了)。

之所以会出现这些“一直在追新,不知所措”的原因是有的朋友孤立地看论文,结果却只能被一片叶子蒙蔽,只有行道树,没有森林。正确的坐姿应该是梳理一个知识的上下文,然后在阅读一篇论文的时候,根据这个上下文进行分类,比如一篇文章在哪个分支上得到了改进。以后遇到实际问题,先拆解问题,再去包含问题的分支寻找合适的解决方案。只有这样,你才能真正整合每篇论文的观点。论文看多了,对知识的把握就会越清晰,不是“熊断棍子”,而是越看越糊涂。

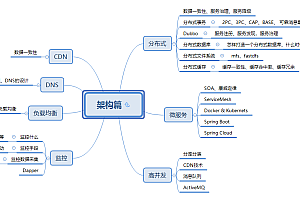

本文介绍了我为“推荐算法”整理的上下文。我用 5 个关键词来总结推荐算法,称之为“三环”。其实这些整理方式只是我家的话,还有其他的角度。 “看脊,侧成峰”,只要能建立起属于自己的清晰的知识体系,没有对错。

第一环:记忆与扩展记忆

我们希望推荐系统记住什么?必须记住这些常见的高频模式。举个简单的例子:

为什么?由于训练样本中有太多的模式和模式,推荐系统只需要记住上次遇到相同的场景,“按药配药”就可以“药到病好了”。

如何记住?在记分卡上

LogisticRegression 是一个非常擅长记忆的模型。据说是模型,虽然是非常大的“记分牌”。

给一个人的最终分数是它所命中的记分卡中所有项目的分数之和。比如中国客户来的时候,预测他想点一个“榴莲包”=SCORE()+SCORE()=5-3.5=1.5,也就是推荐系统猜测他有可能会下令,欲望没那么强烈。 LR('scorecard')模型的特点 LR('scorecard')模型的缺陷

LR强于记忆,弱于扩展。这是另一个例子

不要小看这个问题,关系到企业的生死存亡,也关系到你的老板和你的腰包

扩展

综上所述,为了避免“大众推荐”这个内卷严重的红海,拥抱“个性化精准推荐”的蓝海,推荐算法不能只满足于记住“ common, high-frequency”模式(训练数据中频繁出现),“low frequency, long tail”(训练数据中很少见)模式必须手动挖掘。

如何扩展?

看起来很神秘,虽然粗细的概念被拆解成一系列细度的特征,所以“看山不是山,看水不是水”。还举个馒头和火鸡的例子

这样,只要我们给算法喂的不是粗细的概念,而是细度的特征向量,即使是LR这样记忆力强的算法也可以有扩展的能力。

有没有办法手动展开?

但是,上述方法依赖于手动拆解,也称为“特征工程”,有两个缺点:

既然人工拆解困难且有限,算法能否人工将概念拆解成特征向量?如果你还能想到这一步,那么恭喜你,你已经单脚踏入了深度学习的大门。你已经领悟了“道”,剩下的就只有“技巧”了。

第二个环:嵌入

我将深度学习形象地概括为“无中生有”:

这些“无中生有”的套路就像“上帝说,要有光,就有光”的奇迹。它是建立在谎言之上的,后来变成了初学者口中的“深度学习不需要特殊工程”,给个人“我只做深度学习,不做机器学习”的盲目自信。虽然这些“将特征和函数转化为待优化的变量”的思想并不是深度学习发明的,但早在矩阵分解推荐的“古人”就已经存在,但当时还不叫Embedding,而是称为“隐藏向量”。

嵌入将“精确匹配”更改为“模糊搜索”

深度学习对推荐算法的贡献和改进的核心在于Embedding。如上所述,Embedding 是一种将概念手动分解为特征向量的技术。目标是提高推荐算法的扩展能力,从而人工挖掘这些低频、长尾、小众模式,拥抱“个性化推荐”。 “蓝海”。

嵌入如何提高“扩展”能力?简单来说,Embedding 将推荐算法从“精确匹配”转变为“模糊搜索”,从而可以“推断出其他事物”。

例如,在使用倒排索引的召回中,喜欢“科学”的用户很难推出带有“技术”标签的文章(不考虑反义词扩展),因为“科学”和“技术” "是两个完全不同的词。并且在Embedding之后,我们发现“科学”和“技术”这两个向量不是正交的,而是有一个小的倾角。设想一个极其简化的场景。用户向量用“科学”向量表示,文章的向量只用其标签的向量表示。这样,“科学”向量就被用来在所有标签向量中进行一次Top-K最近邻搜索。一篇带有“科技”标签的文章,将有机会呈现在用户眼前,从而摒弃了之前“只有‘科学’标签完全匹配”带来的“信息茧房”

回到原来包子和火鸡的案例,使用Embedding算法4有那么好吗,算法可以手动学习火鸡和包子的相似度,所以给组合打了高分,所以能更好的给这些喜欢的中国人庆祝海洋节提供更好的个性化服务。

第三环:高维、稀疏的类别特征

与机器学习的其他领域一样,推荐算法中使用的特征分为两大类:

在两类特征中,前者是推荐算法的“一等公民”。按照郭老师的话说,就是贵宾中的“P”,需要我们这群农民工细心服务。

“类别特征”更受欢迎

据说类别被称为“一等公民”,因为它们更受欢迎并且在推荐算法中无处不在:

在现实世界的场景中,“目标和特征”之间几乎没有线性关系。在线工程更有可能落地,高维、稀疏、离散的类别特征优先于“类别特征”享受VIP服务

据说该品类的特点是“一等公民”,二是推荐系统中的很多技术都是专门为更好地服务那些VIP而设计的

如前所述,类别特征的维度非常高,数以万计的标签是非,加上实数特征分桶和多维特征相交,特征空间的维度很容易数以亿计。存储这么多特征的权重和嵌入向量也是一笔不小的开支。类别特征本来就是稀疏的,“实数特征离散化”和“多特征交集”使得特征空间越来越稀疏,稀疏性增加了稀有特征(组合)的训练机会。为了解决这个问题,业界也想出了很多解决方案。第四环:交叉特征

我在介绍三环的时候已经说过,单个特征的表达能力太弱了,所以需要跨多个特征来提升模型的表达能力。

虽然目前主流的基于深度学习的排序算法都是从Wide&Deep衍生而来的,比如DeepFM或者DCN。

环 5:Field&Pooling 哪些是字段?

在不同的文章中,有不同的昵称,有的叫Field,有的叫Slot,有的叫FeatureGroup,但是意思是一样的,都是几个相关特征的集合。

过去我们的LR和FM只有Feature的概念,没有涉及Field,他们做得很好。怎么会有新的Field概念?这还是离不开推荐系统的“高维、稀疏特征空间”:

所以正确的坐姿是,

如何进行池化?

刚才说了,Pooling就是将一个Field下的多个FeatureEmbeddings压缩成一个向量的过程。不同的论文在压缩方式上也各有优势

推荐算法经典套路

充分理解前面5个链接后,你不难理解推荐算法中的经典套路

总结

至此,“推荐5环”已经整理完毕。虽然这5个关键词的“五环”这个名字有点儿玩笑,但也很恰当,因为它们是相通的

推荐三环

将推荐算法梳理成这5个循环,然后阅读论文,你会发现个别论文吹嘘的“显着进步,巨大进步”只是一个循环中的小改进,其他循环。以上使用的方法可能存在缺陷,不值得借鉴。

当你遇到实际问题时,可以先将问题的难度拆解到三个环中的单个环,然后从这些环的研究结果中汲取解决问题的灵感,而不是去抓胡须和寺庙和生病。去看医生。其实有了这5个环组成的知识体系,你脑海中的推荐算法就越来越清晰了,你可以在调参炼丹的日常生活中吃火锅、唱歌、聊天、大笑,“啊,啊,三环算法4有那么好吗,……”