|转载自Github:chenking2020

ChatGPT爆出圈,国内多家院校、研究机构和公司都发布了类似ChatGPT的发布计划。 ChatGPT 不是开源的,并且复制起来极其困难。 即使到了今天,还没有任何单位或企业能够复制 GPT3 的全部功能。 刚刚,OpenAI正式宣布发布图文多模态GPT4模型。 与 ChatGPT 相比,其功能有了大幅提升。 似乎尝到了通用人工智能引领的第四次工业革命的滋味。

无论是国内还是国外,OpenAI与OpenAI的差距都越来越大。 大家都在紧锣密鼓地追赶,从而在这次技术创新中处于一定的优势地位。 目前很多小公司基本上都是在做闭源研发。 Route、ChatGPT和GPT4官方公布的细节很少,而且与之前发表的几十页论文介绍不同,OpenAI的商业化时代已经到来。 当OpenAI不再开放,那么如何打破技术束缚,那就只能寻求开源模式了。 为此,笔者盘点了一些组织或个人的开源模型,总结如下:

聊天袁

ChatYuan(元语AI)由元语智能开发团队开发并发布。 它号称是国外第一个、最早的功能性对话模型。 能写文章、作业、散文、中英文互译; 一些特定领域的问题(例如法律)也可以提供相关信息。 该型号目前仅支持英语。

从披露的技术细节来看,底层采用7亿参数规模的T5模型模型网站源码,基于PromptClue,有监督微调生成ChatYuan。 该模型基本上是ChatGPT三步走技术路线的第一步,并没有实现奖励模型训练和PPO强化学习训练。

GitHub 链接:

巨大的人工智能

最近,ColossalAI 开源了他们的 ChatGPT 实现。 分享了他们的三步走策略,全面实现了ChatGPT的核心技术路线。

基于这个项目,我明确了三步走的策略并分享:

这三个文件的执行需要放在ColossalAI项目中。 代码中的core为原项目中的chatgpt,cores.nn改为原项目中的chatgpt.models。

GitHub 链接:

聊天GLM

ChatGLM是北大技术成果转化公司智普AI开源的GLM系列对话模型。 支持中英文两种语言,62亿参数模型目前已开源。 它继承了GLM以往的优点,优化了模型架构,从而降低了部署和应用门槛,使大型模型能够在消费级主板上进行推理应用。

从技术角度来看,它实现了ChatGPT的增强学习人类对齐策略,使得生成的功效更加贴近人类价值观。 目前的能力领域主要包括自我意识、大纲写作、文案写作、邮件写作辅助、信息提取、角色等。 性能、评论对比、旅游建议等。目前已经开发出1300亿的大规模模型,正在公测,可以算是参数更大的大规模对话模型的开源替代品。

详细技术请参考其GitHub:

拉

LLaMA是Facebook母公司Meta发布的新型人工智能小语言模型。 它在生成文本、对话、总结书面材料、证明物理定律或预测蛋白质结构等任务中表现良好。 LLaMA 模型支持 20 种语言,包括拉丁语和西里尔语。 目前,原型号不支持英语。

LLaMA目前比较流行的两个顶级开源项目是ChatLLaMA和stanford_alpaca。

ChatLLaMA是Nebuly+AI推出的基于人类反馈强化学习的LLaMA+AI聊天机器人的开源实现。 其技术路线与ChatGPT类似。 该项目上线仅2天,已获得5.2K星。

GitHub 链接:

ChatLLaMA 训练过程算法比 ChatGPT 训练更快、更经济。 据说速度快了近15倍。 主要特点是:

另外一个热门的就是最近发布的alpaca(羊驼模型),它是哈佛基于Meta的LLaMA 7B模型微调后的新模型。 基本原理是以自指导的方式使用OpenAI的text-davinci-003模型。 生成 52K 指令样本来微调 LLaMA。 该项目开源了训练数据、生成训练数据的代码和超参数。 模型文件尚未开源。 一天多的时间关注度已达到5.6K星,预计其模型文件很快就会开源供大家使用。

GitHub 链接:

演示地址:

OpenChatKitk

OpenChatKit由前OpenAI研究员Together团队以及LAION和Ontocord.ai团队共同打造。 OpenChatKit 包含 200 亿个参数,并使用 GPT-NoX-20B(GPT-3 的开源版本)进行了微调。 同时,与ChatGPT的增强学习不同,OpenChatKit采用60亿参数的初步审查模型来过滤不适当或有害的信息,以确保生成内容的安全和质量。

GitHub 链接:

美女

在Stanford Alpaca的基础上,实现了基于Bloom和LLama的有监督微调。 斯坦福羊驼的种子任务都是英文的,收集的数据也是英文的。 该开源项目促进了大型英语会话模型开源社区的发展,并针对英语进行了优化。 模型调整仅使用 ChatGPT 生成的数据(不包括任何其他数据)。 该项目包括以下内容:

GitHub 链接:

PalLM-rlhf-pytorch

堪称第一个开源ChatGPT替代项目。 其基本思想基于微软语言大模型PaLM架构,采用人类反馈强化学习(RLHF)的方法。 PaLM是微软今年4月发布的基于Pathways系统训练的5400亿参数全能大模型。 它可以完成编写代码、聊天、语言理解等任务,并且在大多数任务上都具有强大的few-shot学习性能。 同时,它采用了与ChatGPT相同的增强学习机制,可以让AI的答案更加符合情境要求,降低模型毒性。

GitHub 链接:

羊驼-洛拉

alpaca-lora 是斯坦福大学的另一项新作品。 它使用LoRA(低秩适应)技术来重现Alpaca的结果。 它使用越来越低成本的方法,仅在 RTX 4090 主板上训练 5 小时。 与羊驼毛相媲美的款式。 此外,该模型可以在Raspberry Pi上运行。 在这个项目中,它使用Hugging Face的PEFT来实现廉价且高效的微调。 PEFT 是一个库(LoRA 是其支持的技术之一),允许您采用各种基于 Transformer 的语言模型并使用 LoRA 对其进行微调,从而能够在通用硬件上对模型进行廉价且高效的微调。

GitHub 链接:

虽然Alpaca和alpaca-lora有了很大的改进,但它们的种子任务都是英文的,缺乏对英文的支持。 一方面,如上所述,Belle收集了大量的英语语料库。 另一方面,在alpaca-lora等前人工作的基础上,来自华中师范大学等机构的三位个人开发者开源了英语语言模型Camel(骆驼)。 只有这样才能完成训练部署。 目前,该项目已经发布了luotuo-lora-7b-0.1和luotuo-lora-7b-0.3两个型号,另外一个型号正在计划中。

GitHub 链接:

多莉

受到 Alpaca 的启发,Dolly 使用 Alpaca 数据集在 GPT-J-6B 上进行微调。 由于Dolly本身就是该模型的“克隆”,团队最终决定将其命名为“Dolly”。 这种受羊驼启发的克隆品种越来越多。 综上所述,Alpaca的开源数据采集方法一般用于在6B或7B大小的老模型上进行指令微调,以获得与ChatGPT类似的效果。 这个想法非常经济,可以快速模仿ChatGPT的魅力。 一经推出就大受欢迎,成为明星。

GitHub 链接:

骆驼毛和中国骆驼毛

继羊驼推出后,斯坦福大学学者联手CMU、加州大学伯克利分校等推出了新模型——Vicuna(俗称vicuna、llama),拥有130亿个参数。 只需 300 美元即可实现 ChatGPT 90% 的性能。 Vicuna 是通过对 ShareGPT 收集的共享对话进行 LLaMA 微调而获得的。 测试过程采用GPT-4作为衡量标准。 结果表明,Vicuna-13B 在 90% 以上的情况下可以与 ChatGPT 和 Bard 竞争。 能力。

加州大学伯克利分校 LMSys org 最近发布了拥有 70 亿个参数的 Vicuna。 不仅体积小、效率高、功能强大模型网站源码,而且只需两行命令就可以在M1/M2芯片的Mac上运行,而且还可以启用GPU加速!

GitHub 链接:

中文-骆驼毛GitHub地址:

LMF流量

ChatGPT火了以后,大家都在寻找通往寺庙的捷径。 一些ChatGPT之类的东西开始出现,尤其是ChatGPT的低成本模仿已经成为一种流行方式。 LMFlow就是在这些需求场景下诞生的产品。 能够在3090等普通主板上构建大型模型。该项目由香港科技大学统计与机器学习实验室团队发起,致力于打造一个完全开放的大型模型研究平台,支持各类实验在有限的机器资源下,借助方法和优化来提高平台现有数据的算法效率,使得平台能够发展成为比之前的方法更加高效的大模型训练系统。

该项目使用户能够支持专业领域的个性化培训,即使估算资源有限。 例如LLaMA-7B,一台3090可以在5小时内训练完毕,成本大幅降低。 该项目还开放了基于网络的即时问答服务(lmflow.com)。 LMFlow的出现和开源使得普通资源能够训练问答、陪伴、写作、翻译、专家现场咨询等各种任务。 目前,许多研究人员正在尝试使用该项目来训练具有 650 亿或更多参数的大型模型。

GitHub 链接:

GPT万亿

这个项目堪称最大的开源模型,高达1.5万亿,而且是多模态模型。 其能力领域包括自然语言理解、机器翻译、智能问答、情感分析、图文匹配等。

其开源地址为:

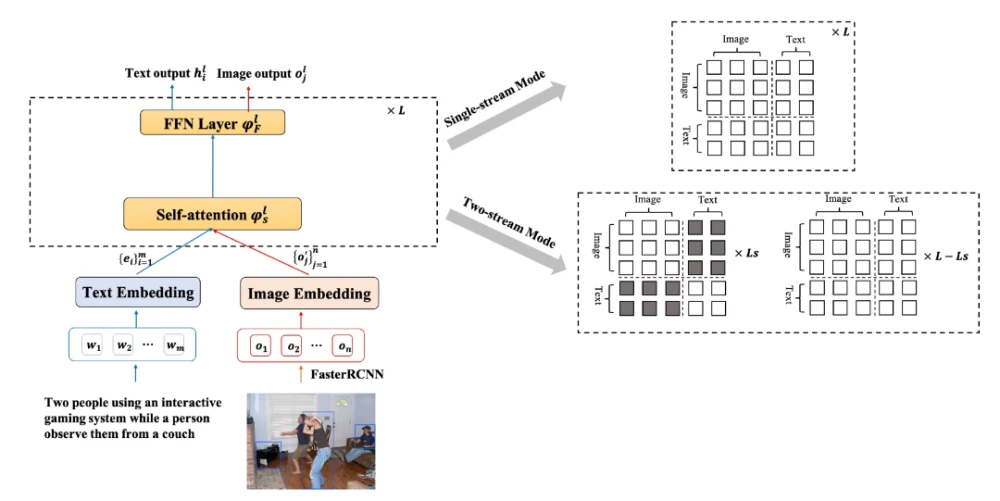

开放火烈鸟

OpenFlamingo 是一个以 GPT-4 为基准的框架,支持小型多模态模型的训练和评估。 它由非营利组织 LAION 作为开源发布。 它是 DeepMind 的 Flamingo 模型的复制品。 目前开源的是其基于LLaMA的OpenFlamingo-9B模型。 Flamingo 模型在包含交错文本和图像的大规模互联网语料库上进行训练,并具有上下文小样本学习能力。 OpenFlamingo 实现了与原始 Flamingo 中提出的相同架构,使用来自新的多模态 C4 数据集的 500 万个样本和来自 LAION-2B 的 1000 万个样本进行训练。

项目开源地址:

白泽白泽

该项目提出了一种手动采集ChatGPT对话的方法,让ChatGPT能够自言自语,批量生成高质量的多轮对话数据集。 它从 Quora、StackOverflow 和 MedQA 收集了约 50,000 个高质量问答语料库,并且全部已开源。 同时改进了LLama模型,效果还不错。 百泽还利用目前低成本的LoRA微调方案,获得了Baize-7B、13B和30B三种不同尺度,以及医疗垂直领域的模型。 可惜英文名虽好,但还是不支持英文。 据了解,中国百泽车型正在规划中,未来将会发布。

其开源github地址:

考拉

基于LLama的ChatGPT替代品,UC Berkeley的Berkeley发布了可以在消费级GPU上运行的对话模型Koala,参数达到13B。 Koala 的训练数据集包括以下部分:ChatGPT 数据和开源数据(OpenInstruction Generalist (OIG)、Stanford Alpaca 模型使用的数据集、Anthropic HH、OpenAI WebGPT、OpenAI Summarization)。 Koala模型在EasyLM中使用JAX/Flax实现,使用8块A100 GPU,完成2轮迭代需要6小时。 评估效果优于Alpaca,达到ChatGPT性能的50%。

开源地址:

堆栈LLaMA

随着哈佛羊驼的出现,大量以 LLama 为基础的小马科和扩展的植物科开始出现,最后 Hugging Face 研究人员最近发布了博客 StackLLaMA:使用 RLHF 训练 LLaMA 的实用手册。 同时,还发布了70亿参数模型——StackLLaMA。 这是通过人类反馈增强学习,在 LLaMA-7B 上微调的模型。

详细见其博客地址: