人工智能的分类有哪些?

人脑机对接技术项目名称:小毛猫

人工智能领域的六大类:

1、深度学习:

深度学习是基于现有数据的学习操作。它是机器学习研究的一个新领域。机器在于构建和模拟人脑的神经网络进行分析和学习。 ,例如声音和文字。深度学习是一种无监督学习。

2、自然语言处理:

自然语言处理是一种使用自然语言与计算机进行通信的技术。人工智能的一个分支,研究利用电子计算机模拟人类语言交流的过程,使计算机能够理解和使用人类社会的自然语言如汉语、英语等,实现自然语言交流人与机器之间,并取代了人类部分的脑力工作,包括查询数据、回答问题、提取文档、编译数据,以及处理所有相关的自然语言信息。例如,电话机器人在生活中的核心技术之一就是自然语言处理。

3、计算机视觉:

计算机视觉是指利用相机和笔记本代替人眼来识别、跟踪和检测物体等机器视觉,并进一步进行图形处理,使笔记本处理成为更适合人眼观察或传输的图像测量仪器;计算机视觉是利用各种成像系统代替视觉器官作为输入敏感的手段,用计算机代替大脑完成处理和解释。计算机视觉的最终研究目标是使计算机能够像人类一样通过视觉来观察和理解世界,并具有自主适应环境的能力。有许多计算机视觉应用示例,包括用于控制流程、导航、自动检查等。

4、智能机器人:

如今,很多智能机器人正逐渐出现在我们身边。它们具有视觉、听觉、触觉、嗅觉等各种内部信息感知和外部信息感知。除了拥有体验者之外,它还拥有效应器作为对其周围环境起作用的一种手段。这种机器人离不开人工智能的技术支持;科学家认为,智能机器人的发展方向是在机器人身上安装“大脑芯片”,从而使其更加智能。模糊信息的综合处理将向前迈出一大步。

5、自动编程:

手动编程是指根据给定问题的原始描述,手动生成满足要求的程序。它是一个结合软件工程和人工智能的研究课题。手工程序设计主要包括程序综合和程序验证。后者实现手动编程,即用户只需要告诉机器“做什么”而不告诉“怎么做”,后一步由机器手动完成;后者是程序的人工校验,人工校验正确性。其目的是提高软件生产的丰富度和软件产品的质量;手动编程的任务是设计一个程序系统,该系统接受一个非常中间的描述作为其输入的设计程序需要什么来实现某个目标,然后手动生成一个可以实现这个目标的程序。具体程序。这项研究的主要贡献之一是将程序调试的概念用作解决问题的策略。

6、数据挖掘:

数据挖掘一般是指通过算法搜索隐藏在大量数据中的信息的过程。它通常与计算机科学相关,并通过统计、在线分析、情报检索、机器学习、专家系统(借助过去的经验法则)和模式识别来实现。其剖析方法包括:分类、估计、预测、相关分组或关联规则、聚类和复杂数据类型挖掘。

有什么类型的人工神经网络

人工神经网络模型主要考虑网络连接的拓扑结构、神经元的特征和学习规则。目前有近40种神经网络模型,包括反向传播网络、感知器、自组织映射、Hopfield网络、玻尔兹曼机、自适应共振理论等。根据连接拓扑结构,神经网络模型可分为:

(1)前向网络,网络中的每个神经元接受前一阶段的输入,输出到下一阶段。网络中没有反馈,可以用一个有向无分支图来表示。这些网络实现了信号从输入空间到输出空间的变换,其信息处理能力来自于简单非线性函数的多重复合,网络结构简单,易于实现,反向传播网络是典型的前向传播网络。网络。道路。

(2)Feedback network 网络中的神经元之间存在反馈,可以用一个无向完全图来表示。这些神经网络的信息处理是状态变换,可以用动态系统理论来处理。系统的稳定性与联想记忆功能密切相关,Hopfield网络和玻尔兹曼机都属于这种类型。

学习是神经网络研究的重要组成部分,其适应性是通过学习来实现的。随着环境的变化,残差被调整以改善系统的行为。 Hebb 提出的 Hebb 学习规则为神经网络的学习算法奠定了基础。 Hebb 规则指出,学习过程最终发生在神经元之间的突触处,突触的刚度随着突触前后神经元的活动而变化。在此基础上,提出了各种学习规则和算法,以满足不同网络模型的需求。有效的学习算法使神经网络能够通过连接残差的调整来构建客观世界的内部表示,并产生独特的信息处理方法。信息的存储和处理体现在网络的连接上。

根据学习环境的不同,神经网络学习方法可以分为监督学习和无监督学习。在监督学习中,将训练样本的数据添加到网络输入中,将对应的期望输出与网络输出进行比较,得到偏差信号,从而控制残差连接硬度的调整,多次训练后收敛到一定的残留。当样本情况发生变化时,可以学习残差的变化以适应新的环境。使用监督学习的神经网络模型包括反向传播网络、感知器等。在无监督学习中,不预先给出标准样本,直接将网络置于环境中,将学习阶段和工作阶段融为一体。此时学习规律的变化服从连通残差的演化多项式。无监督学习最简单的反例是 Hebb 学习规则。竞争性学习规则是更复杂的无监督学习的反例,其中残差根据完善的降维进行调整。自组织图、自适应共振理论网络等都是与竞争学习相关的典型模型。

研究神经网络的非线性动力学性质,主要利用动态系统理论、非线性规划理论和统计理论分析神经网络的演化过程和吸引子的性质,探索神经网络的协同行为和集体估计函数了解神经信息处理机制。为了说明神经网络在完整性和模糊性方面处理信息的可能性,来自混沌理论的概念和技术将发挥作用。混沌是一个定义相当不精确的物理概念。一般来说,“混沌”是指在由确定性多项式或确定性随机性描述的动态系统中表现出的非确定性行为。 “确定性”是由于其内部原因而不是外部噪音或干扰,而“随机性”是指其不规则、不可预测的行为,只能用统计方法来描述。混沌动力系统的主要特点是对初始条件的敏感依赖,混沌反映了其固有的随机性。混沌理论是指描述具有混沌行为的非线性动力系统的基本理论、概念和方法。它将动力系统的复杂行为理解为它们在与外界交换物质、能量和信息的过程中的固有属性。结构的行为,而不是外来的偶然行为,混沌状态是稳定状态。混沌动力系统的稳态包括:静态解、平稳解、周期解、准同时解和混沌解。混沌轨迹是全局稳定性和局部不稳定性共同作用的结果,称为特殊吸引子。

人工智能有哪些类型?

人工智能是计算机应用的一个方向。其研究领域包括:自然语言处理、知识表示、智能搜索、推理、规划、机器学习、知识获取、组合调度问题、感知问题、模式识别、逻辑程序设计软估计、不精确和不确定性管理、人工生命、神经网络、复杂系统、遗传算法。

常见的语音识别与合成、机器视觉与图像处理、智能机器人和人工驾驶都是人工智能的领域。

人工神经网络是什么意思

一、人工神经网络的概念。

人工神经网络(ANN),简称神经网络(NN),是基于生物学中神经网络的基本原理。它是基于道路拓扑学知识,模拟人脑神经系统对复杂信息的处理机制的物理模型。该模型具有并行分布式处理能力、高容错性、智能性和自学习能力。它结合了信息的处理和存储。以其独特的知识表示方法和智能自适应学习能力,引发了多种学科领域的关注。它实际上是一个由大量简单设备相互连接的复杂网络。它具有高度的非线性,只能进行复杂的逻辑运算和非线性关系。

神经网络是一种运算模型,由大量相互连接的节点(或神经元)组成。每个节点代表一个特定的输出函数,称为激活函数。每两个节点之间的连接表示通过该连接的信号的附加残差,称为权重。神经网络使用这些方法来模拟人类记忆。网络的输出取决于网络的结构、网络的连接形式、权重和激活函数。网络本身在本质上一般是对某种算法或功能的一种接近,也可能是一种逻辑策略的表达。神经网络的构建理念是受生物神经网络运行的启发。人工神经网络将生物神经网络的理解与物理统计模型相结合,利用物理统计工具来实现。另一方面,在人工智能的人工感知领域,我们利用物理统计,使神经网络具备类人的决策能力和简单判断能力。这些方法是对传统逻辑演算的进一步扩展。

在人工神经网络中,神经元处理单元可以表示不同的对象,例如特征、字母、概念或一些有意义的比喻模式。网络中处理单元的类型分为三类:输入单元、输出单元和隐藏单元。输入单元接受来自外界的信号和数据;输出单元实现系统处理结果的输出;隐藏单元是输入单元和输出单元之间的一个单元,系统外部无法观察到。神经元之间的连接残差反映了单元之间的连接硬度,信息的表示和处理体现在网络处理单元的连接关系上。人工神经网络是一种非程序化的、自适应的、大脑式的信息处理。其本质是通过网络的变换和动态行为,获得并行、分布式的信息处理功能。模仿人脑神经系统的信息处理功能。

神经网络是一种物理模型,它使用类似于大脑突触连接的结构进行信息处理。它是一种植根于神经科学、数学、心智科学、人工智能、统计学、物理学、计算机科学和工程科学的技术。

二、人工神经网络的发展。

神经网络的发展历史悠久。其发展历程大致可概括为以下四个阶段。

1.第一阶段——启蒙时期。

(1),M-P神经网络模型:1940年代,人们开始研究神经网络。1943年,意大利心理学家麦卡洛克和物理学家皮茨(Pitts)提出了M-P模型,比较简单,效果也很好在模型中,将神经元作为实现算法的功能逻辑元件,开创了神经网络模型的理论研究。

(2),赫布法则:1949年,心理学家赫布发表了《行为的组织》(The Organisation of Behavior)(行为组织学),其中提出突触连接的刚度是可变的假设。这个假设成立认为学习过程最终发生在神经元之间的突触部位,突触连接的刚度随着突触前后神经元的活动而急剧变化,这一假设发展为后来的赫布法则,在神经网络。一条定律告诉人们,神经元之间突触连接的刚度是可变的,而这些可变性是学习和记忆的基础。赫布定律为构建具有学习功能的神经网络模型奠定了基础。

(3),感知器模型:1957年,罗森布拉特在M-P模型的基础上提出了感知器模型。感知器模型具有现代神经网络的基本原理,但其结构与神经生理学非常吻合。这是一个残差向量连续可调的MP神经网络模型,通过训练可以达到对某些输入向量模式进行分类和识别的目的。看起来比较简单。但它是第一个真正意义上的神经网络。Rosenblatt证明了两层感知器可以对输入进行分类,他还提出了带有隐藏层处理装置的三层感知器的重要研究方向。网络方法和技术。

(4),ADALINE网络模型:1959年,印度著名工程师B. Widrow和M. Hoff等人提出了自适应线性元(简称Adaline)。)和Widrow-Hoff学习规则(也称为最小均值残差算法或delta规则)神经网络训练方法,并将其应用于实际工程,成为第一个解决实际问题的人工神经网络,促进了神经网络的研究、应用和发展. ADALINE网络模型是一种连续值自适应线性神经元网络模型,可用于自适应系统。

2.第二阶段——低谷期。

人工智能的创始人之一明斯基和派普特对以感知器为代表的网络系统的功能和局限性进行了深入的物理研究,并于 1969 年出版了令人震惊的著作《感知器》神经网络bp算法程序c语言实现,强调了一个简单的功能线性感知器是有限的,它无法解决两类不能线性分离的样本的分类问题。这一结论给当时的人工神经网络研究带来了沉重打击。开启了神经网络发展史上10年的低谷。

(1)、自组织神经网络SOM模型:1972年美国院士KohonenT.提出了自组织神经网络SOM(Self-Organizing featuremap)。后来的神经网络主要基于KohonenT。 SOM网络是一种无监督学习网络,主要用于模式识别、语音识别和分类问题,采用“胜者为王”的竞争性学习算法,与原来的感知器有很大不同,其学习训练方法是无监督训练,是一种自组织网络。这些学习训练方法经常被用作在我们不知道存在哪些分类类型时提取分类信息的一种方式。

(2)、自适应共振理论ART:1976年,新加坡格罗斯伯格院士提出了著名的自适应共振理论ART(Adaptive Resonance Theory),其学习过程具有自组织和自组织的特点。自稳定。

3.第三阶段——复兴时期。

(1),Hopfield模型:1982年,澳大利亚化学家Hopfield提出离散神经网络,离散Hopfield网络,有效地推动了神经网络的研究。在网络中,它首先将Lyapunov函数引入其中,后来的研究人员也把李雅普诺夫函数称为能量函数。它证明了网络的稳定性。1984年,霍普菲尔德提出了连续神经网络,网络中神经元的激活函数由离散变为连续。1985年,霍普菲尔德和 Tank 借助 Hopfield 神经网络解决了著名的旅行商问题(TravellingSalesmanProblem)。Hopfield 神经网络是一组非线性微分方程。除了人工神经网络的信息存储和提取功能的非线性物理推广外, Hopfield 的模型提出了动态多项式和学习多项式,也为 ne 提供了重要的公式和参数工作算法。在Hopfield模型的影响下,一大批学者爆发出研究神经网络的热情,积极涉足这一学术领域。由于Hopfield神经网络在诸多方面具有诸多优势,潜力巨大神经网络bp算法程序c语言实现,因此人们对神经网络的研究非常重视,越来越多的人开始研究神经网络,极大地促进了神经网络的发展。

(2),玻尔兹曼机模型:1983年,Kirkpatrick等人意识到可以用模拟固溶算法求解NP完全组合优化问题,模拟低温物体的固溶过程该方法最早由 Metropli 等人于 1953 年提出,1984 年 Hinton 与青年学者 Sejnowski 等人合作提出了大规模并行网络学习机,并明确提出了隐藏单元的概念,这些学习机器后来被称为玻尔兹曼机器。

Hinton 和 Sejnowsky 以统计数学的推崇和方法,首先提出了一种多层网络学习算法,称为玻尔兹曼机模型。

(3),BP神经网络模型:1986年,D.E. Rumelhart等人提出了基于多层神经网络模型的多层神经网络残差校正。反向传播学习算法,BP算法(ErrorBack-Propagation),解决了多层前向神经网络的学习问题,证明了多层神经网络具有很强的学习能力,可以完成很多学习任务,解决很多实际问题。

(4), Parallel Distributed Processing Theory: 1986 年,Rumelhart 和 McCkekkand 主编的《Parallel Distributed Processing: Exploration in the Microstructures of Cognition》,他们在其中建立了并行分布式处理的理论,主要针对认知的微观研究同时详细分析了具有非线性连续传递函数的多层频域网络的偏置反向传播算法,即BP算法,解决了没有有效算法进行残差调整的困境多年来,无法解决的问题回答了《感知器》一书中关于神经网络的局限性的问题,并在实践中否认了人工神经网络具有强大的计算能力。

(5), Cellular Neural Network Model: 1988 年,Chua 和 Yang 提出了 Cellular Neural Network (CNN) 模型,这是一个以元胞自动机为特征的大规模非线性计算机模拟系统。Kosko A one-方式构建联想记忆模型(BAM),具有无监督学习能力。

(6)、达尔文主义模型:爱德曼提出的达尔文主义模型在1990年代初期影响很大,他构建了神经网络系统理论。

(7), 1988 年,Linsker 提出了一种新的感知器网络自组织理论,并在 Shanon 的信息论的基础上产生了最大互信息论,从而点燃了基于 NN 的信息应用之光理论。

(8), 1988, Broomhead 和 Lowe 提出了径向基函数 (RBF) 的层次网络设计方法,然后将 NN 的设计与数值分析和线性自适应混合联系起来。

(9),1991年,哈肯将协作引入神经网络。在他的理论框架中,他认为认知过程是自发的,并得出结论模式识别过程就是模式生成过程。

(10), 1994年廖小新提出了细胞神经网络的物理理论和基础,带来了该领域的新进展。通过扩展神经网络的激活函数类,给定的更一般的延迟细胞神经网络 (DCNN)、Hopfield 神经网络 (HNN) 和双向联想记忆网络 (BAM) 模型已经开发出来。

(11),1990年代初,Vapnik等人提出了支持向量机(SVM)和VC(Vapnik-Chervonenkis)维度的概念。

经过多年的发展,已经提出了数百种神经网络模型。

人工神经网络的学习类型

学习是神经网络研究的重要组成部分,其适应性是通过学习来实现的。随着环境的变化,残差被调整以改善系统的行为。 Hebb 提出的 Hebb 学习规则为神经网络的学习算法奠定了基础。 Hebb 规则指出,学习过程最终发生在神经元之间的突触处,突触的刚度随着突触前后神经元的活动而变化。在此基础上,提出了各种学习规则和算法,以满足不同网络模型的需求。有效的学习算法使神经网络能够通过连接残差的调整来构建客观世界的内部表示,并产生独特的信息处理方法。信息的存储和处理体现在网络的连接上。

类别

根据学习环境的不同,神经网络学习方法可以分为监督学习和无监督学习。在监督学习中,将训练样本的数据添加到网络输入中,将对应的期望输出与网络输出进行比较,得到偏差信号,从而控制残差连接硬度的调整,多次训练后收敛到一定的残留。当样本情况发生变化时,可以学习残差的变化以适应新的环境。使用监督学习的神经网络模型包括反向传播网络、感知器等。在无监督学习中,不预先给出标准样本,直接将网络置于环境中,将学习阶段和工作阶段融为一体。此时学习规律的变化服从连通残差的演化多项式。无监督学习最简单的反例是 Hebb 学习规则。竞争性学习规则是更复杂的无监督学习的反例,其中残差根据完善的降维进行调整。自组织图、自适应共振理论网络等都是与竞争学习相关的典型模型。

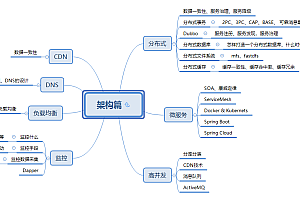

人工智能的分类

人工智能是研究和开发用于模拟、延伸和扩展人类智能的理论、方法、技术和应用系统的新技术科学。人工智能领域的研究包括机器人、语言识别、图像识别、自然语言处理、专家系统等。

人工智能,英文缩写为AI。它是研究和开发用于模拟、延伸和扩展人类智能的理论、方法、技术和应用系统的一门新技术科学。

人工智能是计算机科学的一个分支,它试图理解智能的本质,并可以产生一种新的智能机器,它可以以类似于人类智能的形式做出反应。该领域的研究主要包括机器人、语言识别、图像识别、自然语言处理和专家系统等。

人工智能诞生以来,理论和技术日趋成熟,应用领域不断扩大。可以想象,未来人工智能带来的科技产品将是人类智能的“容器”。人工智能可以模拟人类意识和思维的信息过程。即使人工智能不是人类智能,它也可以像人类一样思考,并最终可能超越人类智能。

优点:

1、在生产方面,更高效、成本更低的机器和人工智能实体取代人类的各种能力,人类的劳动力将得到极大的解放。

2、人类环境问题会得到一定程度的改善,更少的资源可以满足更大的需求。

3、人工智能可以增强人类理解和适应世界的能力。

缺点:

1、人工智能代替人类做各种事情,人类的失业率将大幅上升,人类将处于无奈生存的状态。

2、如果不能合理利用人工智能,就有可能被坏人利用来犯罪,人类将陷入极度恐慌。

3、如果我们不能很好地控制和利用人工智能,反而会被人工智能控制和帮助,人类就会走向没落,世界就会出现恐慌。

什么是人工智能算法

同意前面的回答,我补充一下

决策树

决策树是根据已知的各种情况发生的概率,通过形成决策树得到净折扣的期望值小于或等于零的概率,来评估项目风险,并确定其可行性。决策分析方法直观。使用概率分析的图形方法。因为这些决策分支像树冠一样以图形方式绘制,所以被称为决策树。

随机森林

在机器学习中,随机森林是由多棵决策树组成的分类器,但输出类别是由某些树输出的类别的模式决定的。

逻辑回归

逻辑回归是一种广义线性回归分析模型,常用于数据挖掘、人工癌症诊断、经济预测等领域。例如,解释导致癌症的危险因素,并根据危险因素预测疾病发生的概率。

Adaboost

Adaboost 是一种迭代算法。其核心思想是针对同一个训练集训练不同的分类器(弱分类器),然后将弱分类器集合起来形成更强的最终分类器(强分类器)。分类器)。

算法本身是通过改变数据分布来实现的。 It determines the residual of each sample based on whether the classification of each sample in each training set is correct and the exact rate of the previous overall classification.

Naive Bayes

Naive Bayesian method is a classification method based on Bayesian law and the assumption of independence of characteristic conditions. The two most widely used classification models are decision tree models and naive Bayesian models.

Compared with the decision tree model, the Naive Bayes classifier originated from classical physical theory, has a solid physical foundation, and has stable classification efficiency. At the same time, the naive Bayesian classifier model requires very few parameters, is not sensitive to missing data, and the algorithm is relatively simple.

K-nearest neighbors

The so-called K-nearest neighbor algorithm is that given a training data set, for a new input instance, find the K instances (that is, the K neighbors mentioned above) that are most adjacent to the instance in the training data set. The majority of the K instances belong to a certain class, and the input instance is classified into this class.

SVM

Using the hinge loss function to estimate the empirical risk and adding a regularization term to the solution system to optimize the structural risk, it is a classifier with sparsity and robustness.

Neural Network

Artificial neural network is a technical reproduction of biological neural network in a simplified sense. Its main task is to build a practical artificial neural network model according to the principle of biological neural network and the needs of practical applications, design The corresponding learning algorithm simulates certain intelligent activities of the human brain, and is then technically implemented to solve practical problems. Therefore, the biological neural network mainly studies the mechanism of intelligence; the artificial neural network mainly studies the realization of the intelligent mechanism, and the two complement each other.

Artificial intelligence neural network

1.

x=2.0,w=2.3,b=-3.

y=wx+b=1.6

1)The hard limit is 1 if it is less than 0, and 0 if it is greater than or equal to 0, so the answer is 1.

2)What is the input of the linear function, what is the output, so the answer is 1.6.

3)The logarithmic-sigmoid function should be the sigmoid function, y=1/(1+e^(-1.6))=0.832 .

2.You made a typo? Did you type "yes" into "when"?

x=2.0,w=2.3,b=-3.

y=wx+b=1.6

1)The net input to the transfer function is 1.6

2)The output of the neuron is 1.6 (the transfer function is not given, so this may be the output without the transfer function.).

3.

1)6 inputs, 2 outputs, so 8 neurons.

2)6 w, so 6 dimensions

3)Using the sigmoid function, the output will be a continuous value between 0 and 1.

4)In order to make the network have better performance, to enhance fault tolerance and storage capacity, bias values can be used.

The above answers are for reference only. The first question should be no problem, the last two questions are not so sure.

Original: The difference between artificial intelligence and neural network, what kinds of artificial neural network are there - wooden sword advertisement