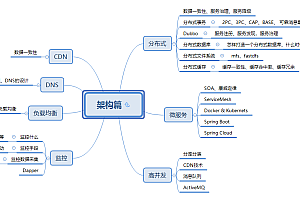

课题基于Python XXXXXX的网络爬虫设计与实现 授课教师:XXXXXX2018 本课题主要目的是介绍网络爬虫的历史和发展历程,介绍网络爬虫的一些常用算法,基于算法实现简单的网络爬虫,并探索网络爬虫的动态爬行策略。 网络爬虫出现的时间并不晚,但在当今的大数据时代,却得以迅速发展。 类型有很多种,不同类型的爬虫的区别就在于资源的选择。 我重点关注的基础网络爬虫通过Python语言的BeautifulSoup分析网站资源,获取对应的URL; 它通过重复来消除重复的 URL。 然后,我还详细阐述了网络爬虫中的动态爬行问题。 随着互联网的发展,AJAX的动态更新技术越来越受到Web开发人员的青睐。 原有的爬取方式很难抓取动态页面。 为了适应不同的需求,我们在编译网络爬虫之前需要根据预设的目标仔细分析资源所在的网站。 我选择了不同的方式来实现动态目标获取。 关键词:网络爬虫、Python、目标获取 1.1 网络爬虫的历史……………………………………………………………………41.2 网络爬虫的定义…………………… ………………………52.1 搜索策略分析……………………………………………………62.1.1 深度优先搜索策略………………………… ……………………62.1.2 长度优先搜索策略……………………………………………………62.1.3 聚焦搜索策略…………………… ………………………………………72.2 使用的语言………………………………………………………………82.3 使用的按键解释器……………… ………………………………………………83.1 爬虫流程……………………………………………………………… 93.2 确定需求…… …………………………………………………………93.3 分析目标…………………………………………………… …………10系统设计与运行………………………………………………134.1 系统设计…………………………………………………………134.2 代码编译…… …………………………………………134.3 运行爬虫………………………………………………15 结论………………………… …………………………………………18 谢谢…………………………………………………………19 参考文献……………………………… ……………………………………20 网络爬虫是一种根据特定模式主动捕获内容中包含的信息的程序或脚本。

网络搜索帮助用户从万维网上下载内容。 当前,人们寻找内容的需求越来越大,互联网发展越来越快。 这时候就出现了一些浏览器之类的搜索引擎,可以在他们的软件上浏览信息。 您可以找到您想要的答案。 如今,社会正在飞速发展。 每个用户都有很多想知道的问题。 他们都去搜索引擎搜索问题。 这时候对互联网的要求就变得更高了。 互联网是一个巨大的数据库,拥有大量的数据。 人们通过它来寻找资源,它的价值就在于它上面丰富的信息可以帮助人们进一步加深对事物的认识。 然而,随着互联网的快速发展,里面的内容也参差不齐,也存在一些缺失和不好的答案。 当然,搜索引擎可以定制并且可以执行各种任务。 然而,作为通用软件,传统搜索引擎必然是其中的一部分。 不要限制专业性而降低其多功能性,这对于传统搜索引擎来说是不够的。 由于人们的搜索目的不同,搜索结果与自己想要的有很大差异,包括废话、虚假广告等等。 为了让搜索更加真实、准确地搜索到优质内容,针对性强的爬虫在某些方面发挥着非常重要的作用。 第一章概述 1.1 网络爬虫的历史 互联网早期,网站上的内容相对较少,查找信息很容易。 然而,互联网发展如此之快,普通网民很难像大海捞针一样找到自己感兴趣的信息。 于是,更加精准的搜索网站应运而生网站爬虫程序,以满足公众信息的需求。

1990年由蒙特利尔大学的Alan Emtage创建的搜索引擎诞生了。 由于距离万维网的创建还有四年,人们不断需要通过网络传输文件,这使得文件传输协议 (FTP) 软件成为文件共享的主要工具。 大多数位置都位于不同位置的 FTP 主机中。 这会导致该文件无法被搜索。 对于无法自动搜索的文件,他可以从互联网上搜索文件。 不仅获取文件名,还获取省级文件的地址信息,即FTP地址。 相比之下,常用的搜索引擎软件和Archie的操作方法是一样的。 不过,截至目前,Archie作为第一个FTP爬虫软件,与今天的爬虫还是有一些区别的。 它在寻找事物方面仍然存在缺陷。 搜索的东西是固定格式的,不能是各种类型的。 就像现在网上的图片一样,很难获取。 因此,与现在的爬虫程序相比,它是第一个被下载的程序。 它不包含任何机器程序,因此无法在互联网上搜索丰富的网络信息。 作为一个爬虫程序,其核心是集合。 它将在互联网上搜索任何具有固定格式FPT的东西,从而实现其信息收集功能。 随着互联网的快速发展,爬虫想要收集互联网上的所有页面已经是一项不可能完成的任务。 因此,一些程序员在传统蜘蛛程序的基础上结合Web Wanderer进行了一些改进。 这个观点就像蜘蛛一样。 它不是随机徘徊,而是通过一些可能保存信息的渠道逐渐找到目标信息。

因为每个页面都包含链接,每个链接都指向另一个地址。 然后可以通过遍历包含链接的页面来抓取整个互联网。 到了上个世纪,基于这个原理,程序员已经制作了一些可用的软件来提高人们的搜索能力。 机器人会手动检查与您通过预先设置的程序输入的信息相关的链接,并将其显示在您的桌面上。 网络发展非常快。 机器人已经跟不上它的速度了,在庞大的网络中搜索信息的速度也变慢了。 ,最后变得完全无法使用。 由于无法使用,将被新程序替代。 WWW蠕虫此时取代了它。 与机器人不同的是,它可以手动分类,让用户更好、更直观地查看资源。 REBS蜘蛛利用这种常用关键词对人们搜索的信息结果进行排名,就像今日头条、热搜榜一样,所以rbse是第一个在处理结果优化和使用关键词时使用它的。 但搜索引擎并没有真正的用处。 Mauldin开始观察Leavitt程序,在更改了一些关键部分后,他将其用在自己的搜索软件中,创建了Lycos。 同年,大卫·费罗和杨致远创立了雅虎。 一开始,网站只是一个收藏界面。 之后,他们开始减少互联网上的链接数量,并且随着推广,越来越多的人访问他们的网站。 后来,他们扩大了规模,组建了团队。 为了让人们更好的搜索,雅虎降低了搜索框,因为它以前的输入法是自动的,所以当时雅虎并没有被认可为搜索引擎,但是它的搜索框有很大的好处,所以人们经常会想到它作为搜索引擎目录。

此后,雅虎开始开发完全手动的集合,并使其难以区分引擎及其目录,这使其在互联网上拥有了自己的地位。 目前,互联网上有很多搜索引擎,它们包含的数据量远远超过了原来的水平。 例如,百度现在在中国占据主导地位,微软在美国也占据主导地位。 他们的数据库富含数亿个链接。 21世纪的明天,网络爬虫已经成为互联网搜索引擎的核心。 纵观搜索引擎和网络爬虫的历史,我们可以发现它们是同时进行的。 从简单的爬虫到大规模分布式、高度集群化等,虽然爬虫的出现还不到30年,但这种发展远远领先于任何其他行业,这也说明了它对互联网发展的重要性。 1.2 网络爬虫的定义 网络爬虫可以主动遍历互联网上包含的网页内容,帮助搜索引擎搜索万维网以下载其需要的资源。 我们对于网络爬虫的流程也非常清楚。 爬虫使用指定的默认页面开始运行程序。 首先,通过分析出的网页上的有用内容来检索URL列表。 这样就可以通过获取原始网页上的URL链接来下载与其相关的网络信息。 然后,不断地从下载的页面中分析出尚未爬取的URL链接,并将其加载到URL管理器中等待爬取。 最后,当所有的URL都爬取完毕后,程序结束。 网络爬虫是基本爬虫的升级版。

它保留了部分基本的Web程序,但保存时并没有保存所有爬取的内容。 相反,丢弃与主题几乎没有相关性的网页。 高度相关的链接被保存并放入要爬行的 URL 队列中; 然后,在搜索完当前页面后,根据队列中每个链接的值选择下一个要分析的页面网站爬虫程序,并重复该过程。 爬行器按计划中止。 第二节相关技术介绍 2.1 搜索策略分析 从里面对网络爬虫的定义可以看出,网络爬虫的关键是如何通过人们想要的关键词或者某个超链接来搜索人们需要的链接。 链接,然后用它来搜索或链接到网站上的时间。 这就是目标图的遍历方法。 然后使用这两种方法作为搜索的起点。 2.1.1 深度优先搜索策略:在最早的爬虫中,爬虫的执行策略是采用深度优先。 例如,假设一张图片中有很多点。 我们以某个点作为画面的起点,并将其展开。 其周围最近的点称为点A。那么距离该点最近的点,假设该点是Z。如果在已经访问过的点周围搜索后找不到点Z,则意味着如果没有,则所有点都是可访问的以前没去过那里。 如果此时仍有未遍历过的顶点,则在剩余未开放的点中随机选择任意一个顶点作为新的入口点,并重复上次的访问。 当图中的所有顶点都包含在完成访问队列中时,说明图中的所有顶点都已被访问,遍历结束。

在真实的网络爬虫中,图表上的每个点实际上都是一个 URL。 如果你下载它访问的所有地址,爬虫最后访问的就是一个不包含任何 URL 的 HTML 文件。 当爬虫从解析出的HTML文件中的内容中解析出URL时,爬虫就会停止抓取之前的站点,并对已经爬出的链接进行深入分析。 换句话说,它不会完成对剩余链接的分析。 向上搜索以创建从起始 HTML 文件到最后一个 HTML 文件的路径。 这是一种深度搜索策略。 深度优先搜索仍将基于页面包含的超链接,直到最后爬取的页面不再包含任何超链接,然后爬虫返回到上一个页面。 在解析的 Web 文件中,选择 Web 文件中的下一个 URL。 如果不想再检索URL列,请将URL列留空,这样深度搜索就基本完成了。 深度搜索的优点是可以完成对网站所有链接的全面访问。 虽然网站的结构很复杂,但是并不影响其访问。 缺点是,当一个网站的结构非常复杂并且你想要访问其下面的文件时,程序就会变得太复杂而无法弄清楚如何继续,并且它会停止并最终停止。 为了防止实际操作中出现这种情况,需要对访问级别进行限制。 2.1.2 广度优先搜索策略 当运行扫描操作时,需要专门设计一列来保存以前访问过的点。 在长度优先搜索中,程序首先搜索存储在主页上的所有指向该页面并且是该页面的下一个网页的链接。 获取从第一页开始的所有后续URL访问。通过这些方法,可以访问每一层的链接